Um processador tem, por propósito, realizar operações com dados (que denominamos processamento) normalmente numéricos. Para realizar essas operações o processador necessita em primeiro ligar interpretar que tipo de operação ele irá executar. Em seguida, antes da realização propriamente dita da operação, é necessário que os dados estejam armazenados no dispositivo que irá executar a operação.

Soma, subtração, multiplicação e divisão;

Operação lógica AND, OR, XOR;

Deslocamento à direita, deslocamento à esquerda; Entre outros

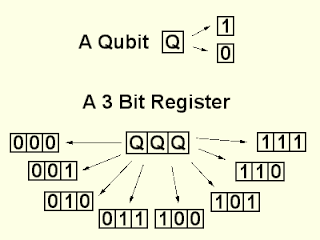

Servem para armazenar dados (ou para guardar resultados), que serão usadas pela ULA, ou resultados parciais das operações.

Para que um dado possa ser transferido pela ULA, é necessário que ele permaneça, mesmo por um breve instante, armazenado em um registrador; Além disto, o resultado de uma operação realizada na ULA deve ser armazenado, temporariamente, de modo a ser reutilizado mais adiante;

A UC é o dispositivo mais complexo do processador. Ele possui a lógica necessária para realizar a

movimentação de dados e instruções “de” e “para” o processador, através dos sinais de controle

que emite em instantes de tempo determinados conforme uma programação prévia.

A figura abaixo mostra o diagrama em bloco simplificado da função controle

O relógio (clock) é um dispositivo gerador de pulsos cuja duração é

chamada de ciclo. A quantidade de vezes em que este pulso básico se repete em um

segundo define a unidade de media do relógio denominada freqüência, a qual também é utilizada para definir

a velocidade da UCP. Servem para: Sincronizar, ou seja, permitir que duas ou mais ações

ocorram no mesmo instante de tempo. Cadenciar as ações realizadas em um determinada positivo,

ou seja, controlar a velocidade com que elas ocorrem.